Czym są duże zbiory danych?

Big data to połączenie ustrukturyzowanych, częściowo ustrukturyzowanych i nieustrukturyzowanych danych gromadzonych przez firmy i organizacje. Często wydobywane w celu uzyskania informacji i wykorzystywane w projektach uczenia maszynowego ang. machine learning, modelowaniu predykcyjnym i innych zaawansowanych zastosowaniach analitycznych.

Systemy przetwarzające i przechowujące dane big data stały się powszechnym elementem architektur zarządzania danymi w organizacjach, w połączeniu z narzędziami obsługującymi zastosowania analizy big data. Big data często określa się trzema literami V:

Large volume – duża ilość danych w wielu środowiskach;

Wide variety – duża różnorodność typów danych często przechowywanych w systemach Big Data;

Velocity – szybkość z jaką większość danych jest generowana, gromadzona i przetwarzana.

Cechy te po raz pierwszy zostały zidentyfikowane w 2001 roku przez Douga Laneya, ówczesnego analityka w firmie konsultingowej Meta Group Inc.; Gartner spopularyzował je dalej po przejęciu Meta Group w 2005 roku. Niedawno zidentyfikowana kilka kolejnych cech „V” do opisania dużych zbiorów danych, w tym prawdziwości, wartości i zmienności. Big data nie określa konkretnej ilości danych. Projekty big data często wiążą się z terabajtami, petabajtami, a nawet eksabajtami danych tworzonych i zbieranych w czasie.

Dlaczego duże zbiory danych są ważne?

Firmy wykorzystują big data w swoich systemach, aby usprawnić operacje, zapewnić lepszą obsługę klienta, tworzyć spersonalizowane kampanie marketingowe czy nawet podejmować decyzje biznesowe. Wszystko w celu zwiększenia przychodów i zysków. Stosowanie big data daje potencjalną przewagę konkurencyjną nad tymi, którzy tego nie robią. Pogląd na szersze spektrum, dzięki dużej ilości danych, znacznie wspomaga podejmowanie decyzji.

Dobrym przykładem na to jest dostarczanie przez big data cennych informacji o klientach wykorzystywanych później do udoskonalenia działań marketingowych, reklam i promocji, zwiększeniu zaangażowania klientów (UX ) i współczynników konwersji w sklepach internetowych. Zarówno dane historyczne, jak i dane w czasie rzeczywistym, można analizować i dokonywać oceny zmieniających się preferencji konsumentów B2C lub B2B. Znacznie szybsza reakcja na potrzeby klientów to już duży sukces dla biznesu.

Big data stało się również popularnym terminem wśród naukowców medycznych. Wykorzystują je do identyfikowania objawów chorobowych i czynników ryzyka oraz przez lekarzy do diagnozowania chorób i stanów chorobowych u pacjentów. Ponadto, połączenie danych z elektronicznych kart zdrowia, serwisów społecznościowych, sieci i innych źródeł, zapewnia organizacjom opieki zdrowotnej i agencjom rządowym aktualne informacje na temat zagrożeń lub epidemii chorób zakaźnych.

Oto kilka przykładów wykorzystania Big Data przez organizacje:

W branży energetycznej, big data pomaga firmom naftowym i gazowym identyfikować potencjalne miejsca odwiertów i monitorować funkcjonowanie rurociągów; podobnie jest w przypadku przedsiębiorstw użyteczności publicznej, które używają danych do śledzenia poprawności funkcjonowania sieci elektrycznych.

Firmy świadczące usługi finansowe wykorzystują systemy big data do zarządzania ryzykiem i analizy danych rynkowych w czasie rzeczywistym.

Producenci i firmy transportowe polegają na big data, aby zarządzać swoimi łańcuchami dostaw i optymalizować trasy dostaw.

Inne zastosowania rządowe obejmują reagowanie w sytuacjach kryzysowych, zapobieganie przestępczości i inicjatywy dotyczące inteligentnych miast.

Korzyści biznesowe wynikające z wykresu Big Data:

- dokładniejszy wgląd w persony użytkowników,

- usprawnienie pracy działów,

- dokładniejszy wywiad rynkowy,

- zarządzanie łańcuchem dostaw w stylu agile,

- decyzje oparte na dużych danych,

- trafne reakcje na zachowanie rynków i trendów.

Przykład wizualnej segmentacji big data

Jakie są przykłady big data?

Big data pochodzi z niezliczonych źródeł – niektóre przykłady to systemy przetwarzania transakcji, bazy danych klientów, dokumenty, e-maile, dane medyczne, internetowe statystyki, zachowania użytkowników, informacje z aplikacji mobilnych i mediów społecznościowych. Kolejne źródła to również dane generowane maszynowo, takie jak pliki dzienników sieci i serwera oraz dane z czujników na maszynach produkcyjnych, sprzęcie przemysłowym i urządzeniach Internetu rzeczy.

Oprócz danych z systemów wewnętrznych środowiska big data, często wliczamy również dane zewnętrzne dotyczące konsumentów, metryk strony i SEO , rynków finansowych, warunków pogodowych i drogowych, informacji geograficznych, badań naukowych i innych. Obrazy, wideo i pliki audio również doskonale wpisują się w zakres big data, a wiele aplikacji opartych na technologii big data, wymaga strumieniowego przesyłania danych. Te z kolei są przetwarzane i gromadzone w sposób ciągły.

Dokładniej o „V” w big data

Wolumen (ang. volume) jest najczęściej przytaczaną cechą big data. Środowisko danych big data nie musi zawierać dużej ilości danych. Zdecydowanie bardziej liczy się charakter danych, które są w nim gromadzone i przechowywane. Strumienie kliknięć, logi systemowe i systemy przetwarzania strumieni to jedne ze źródeł, które zazwyczaj generują na bieżąco ogromne ilości danych.

Big data obejmuje również szeroką gamę typów danych, w tym:

dane strukturalne, takie jak transakcje i dokumenty finansowe;

dane nieustrukturyzowane tj. tekst, dokumenty i pliki multimedialne;

dane częściowo ustrukturyzowane, takie jak logi serwera WWW i dane przesyłane strumieniowo z czujników.

Może zaistnieć potrzeba wspólnego przechowywania różnych typów danych (ang. variety) i zarządzania nimi w systemach Big Data. Ponadto, agregaty Big Data zazwyczaj posiadają wiele zestawów danych, które mogą nie być od razu zintegrowane. Dobrym przykładem na to jest projekt analizy big data, którego celem jest prognozowanie sprzedaży produktu, korelując dane dotyczące wcześniejszych sprzedaży, zwrotów, recenzji online i rozmów z obsługą klienta.

Prędkość (ang. velocity) odnosi się do szybkości, z jaką dane są generowane, przetwarzane i analizowane. Ma to ogromne znaczenie w tej dziedzinie. W wielu przypadkach zbiory big data są aktualizowane w czasie rzeczywistym lub prawie w czasie rzeczywistym, zamiast codziennych, tygodniowych lub miesięcznych aktualizacji dokonywanych w wielu tradycyjnych agregatach danych. Zarządzanie prędkością agregowania danych to bardzo istotna cecha. Analiza big data rozszerza się dalej na uczenie maszynowe (ang. machine learning) i sztuczną inteligencję (AI), w których procesy analityczne automatycznie znajdują wzorce w danych i wykorzystują je do generowania spostrzeżeń.

Więcej cech Big Data

Wychodząc poza oryginalne trzy litery V, warto wspomnieć o innych, nowych cechach na literę „V”:

Wiarygodność odnosi się do stopnia dokładności zbiorów danych i ich wiarygodności. Surowe dane zebrane z różnych źródeł mogą powodować problemy z ich jakością, przez co ich dalsze definiowanie może być trudne. Jeśli nie zostaną naprawione za pomocą procesów czyszczenia danych, złe dane przyczynić się mogą do błędnych wniosków i analiz. Znacznie podważa to wartość inicjatyw z zakresu analityki biznesowej. Zespoły zajmujące się zarządzaniem danymi i analityką muszą również upewnić się, że dane którymi dysponują są na tyle dokładne, aby uzyskać prawidłowe wyniki.

Niektórzy analitycy danych i konsultanci również dodają wartość do listy cech big data. Nie wszystkie zebrane dane mają rzeczywistą wartość biznesową. W rezultacie, firmy muszą potwierdzić, że dane wykorzystane w projektach analizy big data odnoszą się do istotnych problemów biznesowych.

Zmienność (ang. variability) dotyczy także agregatów danych big data, mogących mieć wiele znaczeń lub być różnie sformatowanych w osobnych źródłach danych — czynniki te dodatkowo komplikują zarządzanie i analizę zawartości agregatu big data. Niektórzy eksperci przypisują big data jeszcze więcej cech z literą „V”. W Internecie można znaleźć różne listy zawierające od siedmiu do dziesięciu dodatkowych cech.

Sześć V big data

Charakterystyki big data są powszechnie opisywane za pomocą słów zaczynających się na literę „v” (w języku angielskim). Oto sześć kolejnych cech z literą v.

Jak przechowywane i przetwarzane są duże zbiory danych?

Duże agregaty danych są często przechowywane w jeziorze danych. Podczas gdy hurtownie danych są zwykle budowane na relacyjnych bazach danych i zawierają tylko dane strukturalne, jeziora danych mogą obsługiwać różne typy danych i przeważnie opierają się na klastrach Hadoop, usługach przechowywania obiektów w chmurze, bazach danych NoSQL lub innych platformach Big Data.

Wiele środowisk Big Data łączy rozmaite systemy o rozproszonej architekturze, np. centralne jezioro danych może być zintegrowane z innymi platformami, w tym z relacyjnymi bazami danych lub hurtownią danych. Dane w systemach big data można pozostawić w surowej postaci, a następnie filtrować i porządkować zgodnie z potrzebami na określone zastosowania analityczne. W innych przypadkach są one wstępnie przetwarzane przy użyciu narzędzi data mining (eksploracji danych) i oprogramowania do przygotowywania danych, dzięki czemu są one gotowe do wykorzystania i odczytu.

Przetwarzanie dużych zbiorów danych stawia duże wymagania podstawowej infrastrukturze obliczeniowej. Wymaganą moc obliczeniową często zapewniają systemy klastrowe, które rozdzielają obciążenia przetwarzania na setki lub tysiące popularnych serwerów, wykorzystując technologie takie jak Hadoop i silnik przetwarzania Spark.

Uzyskanie tego rodzaju mocy przerobowych w opłacalny sposób jest wyzwaniem. Chmura jest popularną lokalizacją dla systemów Big Data. Organizacje mogą wdrażać własne systemy oparte na chmurze lub korzystać ze specjalnie zaprojektowanych ofert Big Data, jako usługi od dostawców chmury. Użytkownicy chmury mogą skalować wymaganą liczbę serwerów na tyle, aby ukończyć projekty analizy big data. Firma płaci tylko za pamięć i czas obliczeniowy, z których korzysta, a instancje w chmurze można wyłączyć i uruchomić dopiero, gdy będą znów potrzebne.

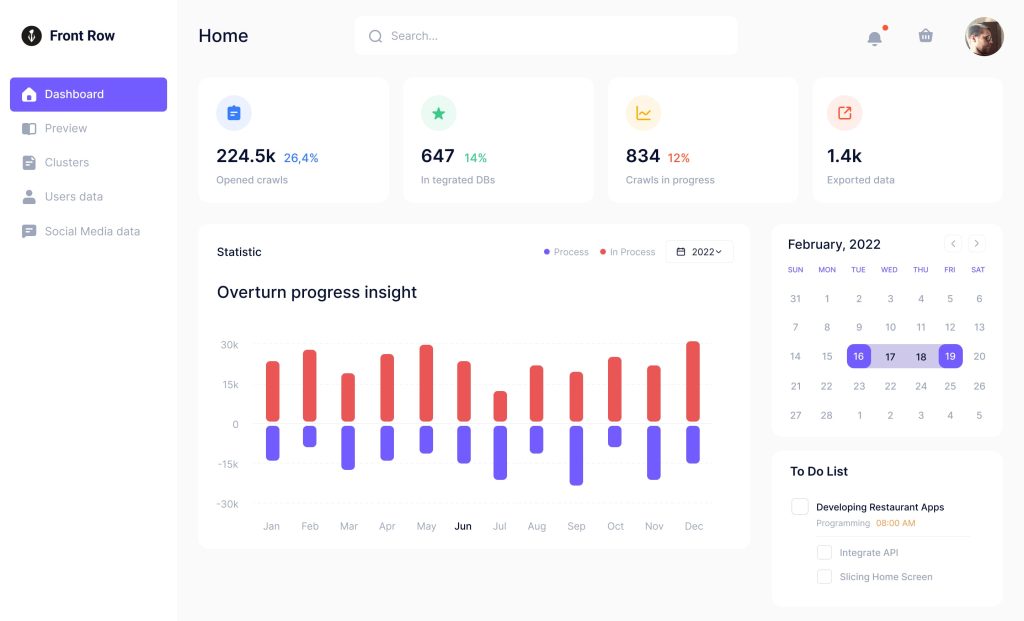

Przykład panelu ze zintegrowanymi technologiami big data

Jak działa analiza dużych zbiorów danych

Aby uzyskać prawidłowe i trafne wyniki z aplikacji do analizy dużych zbiorów danych, analitycy danych muszą mieć szczegółową wiedzę na temat dostępnych danych i wyczucie, czego w nich dokładnie szukają. Przygotowanie danych obejmujące takie czynności jak profilowanie, czyszczenie, walidację i modyfikację jest kluczowym pierwszym krokiem w procesie analitycznym.

Po zebraniu danych i przygotowaniu ich do analizy, stosowane są różne podejścia zaawansowanej analityki. Na tym etapie włączamy dedykowane narzędzia z funkcjami dopasowanymi do analizy big data. Jest to punkt styku obejmujący uczenie maszynowe (ang. machine learning) i jego odgałęzienie do deep learning, modelowania predykcyjnego (ang. predictive modelling), eksplorację danych (ang. data mining), analizę statystyczną, analizę strumieniową, analizę treści i wiele innych.

Biorąc za przykład dane klientów, wdrażane mogą być różne techniki analizy big data:

Analiza porównawcza.

Analizuje ona metryki zachowań klientów i ich zaangażowanie w czasie rzeczywistym (optymalizacja UX ) w celu porównania produktów, usług i marki firmy z produktami konkurencji.

Nasłuchiwanie mediów społecznościowych.

Analizuje to, co ludzie mówią o firmie lub produkcie w mediach społecznościowych i co może pomóc w identyfikacji potencjalnych problemów oraz docelowych odbiorców kampanii marketingowych.

Analityka marketingowa.

Zapewnia informacje wykorzystywane do ulepszania kampanii marketingowych , ofert promocyjnych produktów, usług i inicjatyw biznesowych.

Analiza sentymentu.

Wszystkie dane zebrane na temat klientów można przeanalizować, aby ujawnić sposób myślenia o firmie lub marce, poziom satysfakcji klienta, potencjalne problemy i drogę do ulepszenia obsługi klienta.

Technologie zarządzania dużymi danymi

Hadoop, platforma typu open source dot. przetwarzania rozproszonego, została wydana w 2006 roku. Początkowo była podstawą spotykaną w większości architektur big data. Rozwój Sparka i innych silników przetwarzania zmonopolizowały rynek i zepchnęły MapReduce (silnik wbudowany w Hadoop) na drugi plan. Wynikową tego procesu jest spory ekosystem technologii big data, mogący zostać wykorzystywany do konkretnych zadań. Często są jednak wdrażane razem.

Platformy Big Data i usługi oferowane przez dostawców IT łączą wiele z tych technologii w jednym pakiecie, przede wszystkim do stosowania w chmurze. Poniżej przedstawiamy kilka przykładów takich usług:

- Amazon EMR (dawniej Elastic MapReduce)

- Platforma danych Cloudera

- Google Cloud Dataproc

- HPE Ezmeral Data Fabric (dawniej MapR Data Platform)

- Microsoft Azure HDInsight

W przypadku firm chcących samodzielnie wdrażać systemy Big Data lokalnie lub w chmurze, poza Hadoop i Spark dostępne są dla nich takie narzędzia jak:

- repozytoria pamięci masowej, np. Hadoop Distributed File System (HDFS) i usługi przechowywania obiektów w chmurze obejmujące Amazon Simple Storage Service (S3), Google Cloud Storage i Azure Blob Storage;

- struktury zarządzania klastrami tj. Kubernetes, Mesos i YARN, ze wbudowanym menedżerem zasobów i harmonogramem zadań Hadoop;

- silniki przetwarzania strumienia, takie jak Flink, Hudi, Kafka, Samza, Storm oraz wbudowane w Spark moduły Spark Streaming i Structured Streaming;

- bazy danych NoSQL takie jak Cassandra, Couchbase, CouchDB, HBase, MarkLogic Data Hub, MongoDB, Neo4j, Redis i pozostałe, podobne technologie;

- platformy data lake i hurtownie danych, w tym Amazon Redshift, Delta Lake, Google BigQuery, Kylin i Snowflake;

- na koniec, zostały nam silniki zapytań SQL takie jak Drill, Hive, Impala, Presto i Trino.

Wyzwania dotyczące dużych zbiorów danych

W związku z problemem wydajności przetwarzania, projektowanie architektury big data stanowi główne wyzwanie dla użytkowników. Systemy Big Data muszą być dostosowane do konkretnych potrzeb stawianych w firmie. Są to często przedsięwzięcia typu DIY, wymagające od zespołów IT zarządzania danymi oraz połączenia odpowiednich zestawów technologii i narzędzi. Wdrażanie i zarządzanie systemami Big Data wymaga również nowych umiejętności w porównaniu z tymi, jakie zwykle posiadają administratorzy baz danych i programiści skupieni na oprogramowaniu w modelu relacyjnym.

Oba te problemy można załagodzić korzystając z usługi zarządzanej w chmurze. Menadżerowie IT powinni uważnie obserwować wykorzystanie chmury, aby mieć pewność, że koszty nie wymkną się spod kontroli. Ponadto, migracja lokalnych zestawów danych i moderowanie obciążenia chmury są procesem bardziej skomplikowanym niż nam się wydaje.

Inne wyzwania związane z zarządzaniem systemami Big Data obejmują udostępnianie danych naukowcom i analitykom danych, zwłaszcza w środowiskach rozproszonych, gdzie funkcjonują różne platformy i magazyny danych. Z pomocą przychodzą tutaj katalogi danych. Posiadają one funkcje zarządzania metadanymi i pochodzenia danych. Sam proces integracji zbiorów big data jest często również skomplikowany. Pamiętajmy, że szczególnie nie ułatwiają tego dwa czynniki: różnorodność i szybkość zbierania danych.

Skuteczna strategia big data

Opracowanie skutecznej strategii Big Data wymaga zrozumienia celów biznesowych i obecnie dostępnych danych. Istotna jest również ocena zapotrzebowania na dodatkowe dane, stanowiące znakomite uzupełnienie. Kolejne kroki, które należy podjąć:

- ustalanie priorytetów planowanych przypadków użycia;

- identyfikowanie nowych potrzebnych systemów i narzędzi;

- plan wdrożenia;

- ocena umiejętności wewnętrznych określających czy wymagane jest przekwalifikowanie lub zatrudnienie.

Aby zapewnić, że agregowane duże zbiory danych będą precyzyjne, spójne i właściwie wykorzystywane, na liście „must have” powinny znaleźć się: program zarządzania danymi i łączone procesy zarządzania jakością danych. Do dobrych praktyk należy także skupienie się na potrzebach biznesowych w zakresie informacji o dostępnych technologiach oraz wykorzystanie wizualizacji danych do pomocy zrozumienia i analizy tych informacji.